Nel 1938 Claude Shannon dimostrò che il flusso di un segnale elettrico attraverso una rete di interruttori, che possono essere "accesi/spenti", segue le regole dell'algebra di Boole. Così l'algebra di Boole diventava immediatamente disponibile per progettare e semplificare i sistemi di commutazione automatica per i telefoni. Questa scoperta nasceva nell'ambito degli studi sulla commutazione telefonica, che Shannon conduceva nei Laboratori Bell, ma si rivelò fondamentale quando si cominciarono a progettare le reti combinatorie degli elaboratori elettronici.

Shannon pose inoltre le basi del moderno sapere informatico in troducendo una terminologia specifica con i termini codice binario e bit (nel senso di binary unit)

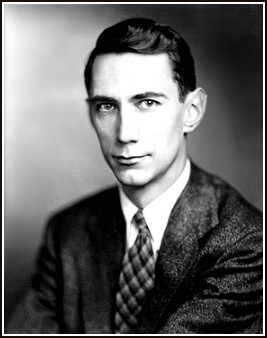

Claude Elwood Shannon (1916 – 2001) fu un importante matematico e ingegnere americano, lontano parente dell’illustre inventore Thomas Edison.

Claude Elwood Shannon (1916 – 2001) fu un importante matematico e ingegnere americano, lontano parente dell’illustre inventore Thomas Edison.

Da ragazzo lavorò come telegrafista per la Western Union.

Nel 1932 iniziò a frequentare l'Università del Michigan dove si laureò in matematica e ingegneria elettronica nel 1936. La tesi che presentò al master del 1938, A Symbolic Analysis of Relay and Switching Circuits (Un’analisi simbolica dei circuiti), stabilì i fondamenti teorici per lo studio dei circuiti digitali collegando le reti logiche elettroniche, come relè ed interruttori, all'algebra booleana.

Nel 1940 Shannon conseguì il dottorato al Massachusetts Institute of Technology (MIT) dove collaborò alla costruzione dell’analizzatore differenziale di Vannevar Bush, un calcolatore analogico che si basava sulla teoria e progettazione di complessi circuiti di relè per risolvere equazioni differenziali.

Nel 1941 iniziò a lavorare come ricercatore-matematico ingegnere presso la Bell Telephones Laboratories, dove rimase fino al 1972.

Nel 1956, anno in cui fu eletto membro della National Academy of Sciences, assieme ad altri studiosi del Dartmouth College (New Hampshire), compì i primi esperimenti sull'Intelligenza Artificiale. In questo periodo inoltre diede inizio alla sua collaborazione con il Massachusetts Institute of Technology; qui dopo due anni iniziò ad insegnare; nel 1978 fu nominato professore emerito.

Nel 1956 Shannon svolse ricerche in settori non propriamente accademici, elaborando diverse macchine "intelligenti" che segnavano insieme ad altri congegni dei molti studiosi dell’epoca le prime basi dell’IA.

Si occupò di problemi di affidabilità affrontati applicando criteri di ridondanza e scrisse i primi programmi sul gioco degli scacchi in cui egli eccelleva in modo particolare. Queste applicazioni erano state create per calcolatore infatti furono utilizzati poi sulla prima macchina (il calcolatore MANIAC, 1956) che giocò una partita contro l’uomo.

Spinto più da una forte curiosità intellettuale che dall’utilità dei diversi ritrovati costruì THESEUS, il topo meccanico comandato da relè che era in grado di trovare da solo la strada per uscire da un labirinto; questo costituì uno dei primi tentativi di “insegnare” a una macchina a “imparare”, rappresentando uno dei primi esperimenti nel campo dell’IA.

Oltre a ciò realizzò il calcolatore THROBAC che eseguiva tutte le operazioni aritmetiche utilizzando i numeri romani, un apparecchio per risolvere il cubo di Rubik e numerosi altri oggetti e giocattoli .

Nel 1938 Claude Shannon con la tesi di master al MIT dimostrò che il fluire di un segnale elettrico attraverso una rete di interruttori, che possono essere "accesi/spenti", segue le regole dell'algebra di Boole. Questa scoperta nasceva nell'ambito degli studi sulla commutazione telefonica che Shannon conduceva nei Laboratori Bell, ma si rivelò fondamentale quando si cominciarono a progettare le reti combinatorie degli elaboratori elettronici. Fino a quel periodo il sistema binario di Boole fondato sulla manipolazione dei numeri “1” e “0” era poco noto, e il lavoro di Shannon contribuì notevolmente alla sua diffusione. Egli pensava, infatti, che questo tipo di logica avrebbe potuto permettere a molte macchine di compiere una grande quantità di diverse operazioni.

Oltre a ricorrere all’algebra booleana egli utilizzò circuiti AND, OR e NOT e le funzioni logiche. Shannon aveva capito che la sua scoperta sarebbe stata accolta nella progettazione delle centrali di commutazione, cioè delle telefoniche automatiche che avrebbero sostituito gli operatori umani con i relè che stabilivano un immediato collegamento tra abbonati. È importante notare però che la tesi dello studioso statunitense fu enunciata quando l’elettronica digitale era alle prime armi, in quanto fino ad allora era stato solo realizzato un circuito di coincidenza ribattezzato da Shannon con il nome “circuito AND”. A Shannon si deve la moderna teoria dell'informazione che elaborò mentre si occupava di crittografia. La sua opera “Teoria matematica della comunicazione”, pubblicata nel 1948 sul Bell System Technical Journal, pose le basi del moderno sapere informatico, introducendo anche una terminologia specifica come codice binario e bit. I suoi studi ottennero risultati rilevanti per quanto concerne la relazione fra quantità di informazione, larghezza della banda trasmessa e rapporto fra segnale e rumore; realizzò inoltre uno studio approfondito della ridondanza. Shannon nella sua opera inoltre approfondì le applicazioni del calcolo delle probabilità al linguaggio.

I punti fondamentali su cui si basa la teoria sono:

"The question is not whether intelligent machines can have emotions, but whether machines can be intelligent without any emotions" Minsky, The Society of Mind